Редакции со всего мира начинают применять в работе искуственный интеллект: анализируют с его помощью большой объём данных, пишут программные коды и даже генерируют контент. Однако общих подходов, как делать это эффективно и этично, пока не выработано – этот процесс начинается только сейчас.

Об успешных и неудачных кейсах применения нейросетей в медиа рассказали на журналистском фестивале в Перудже (Италия) начальник отдела редакционных инноваций The Guardian Крис Моран, исполнительный редактор Associated Press Джули Пейс и директор аналитического центра Лондонской школы экономики Polis Чарльз Бекетт. «Соль» записала главное.

Изображение – Planet Volumes (unsplash.com)

Опыт Associated Press: ИИ-поиск для сайта

В Associated Press искусственным интеллектом пользуются уже десятилетие: ИИ помогает анализировать данные финансовых отчётов, подсчитывает спортивные голы – то есть освобождает команду от рутинных задач. В прошлом году издание начало тестировать новый инструмент Merlin. Это поисковая система сайта на базе ИИ, которая призвана помочь редакции, клиентам и читателям сайта быстрее ориентироваться в контенте Associated Press.

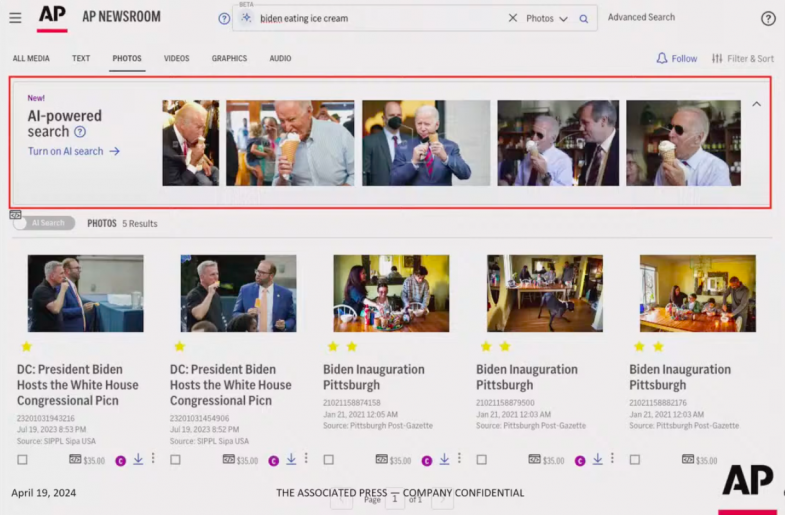

ИИ-поиск понимает суть запроса пользователя, а также анализирует визуальный контент.

«Если мы введём запрос «Джо Байден ест мороженое», сверху мы увидим результаты поиска на базе ИИ – много фотографий Джо Байдена, который ест мороженое. Снизу – результаты обычного поиска, на них вы даже не видите Джо Байдена. Именно таков был наш поисковик раньше. Но Merlin способен брать ваши фразы и превращать их в то, что вы на самом деле ищете», – говорит Джули Пейс.

Скриншот использовался в презентации Джули Пейс

Merlin призван облегчить жизнь журналистам, читателям и клиентам AP – для каждого по своему. Редакция сможет находить нужные тексты, людей, события быстрее. И даже доставать необходимые факты из архивов, которые собирались 177 лет работы Associated Press. Читателям и клиентам также будет проще отыскать релевантные материалы.

«Я начинала карьеру в АР как видеопродюсер. И я часто думаю, сколько времени это бы мне сэкономило, если бы я могла автоматически перейти к точной секунде вместо того, чтобы вручную пролистывать видео», – делится Джули Пейс.

Сейчас инструмент доступен редакции, а также клиентам Associated Press. Его также планируют представить читателям.

Опыт The Guardian: заголовки, саммари, редакционная политика

В The Guardian генеративный ИИ пока только тестируют, но не используют в работе. Однако команде доступны новые инструменты: расширение – креативный помощник журналиста и чат-советчик в вопросах редакционной политики.

«Когда GPT только вышел, я начал экспериментировать. Стал забрасывать журналистские тексты в ИИ и давать задание», – говорит Крис Моран, начальник отдела редакционных инноваций The Guardian.

Крис просил ИИ придумать заголовки для материалов, написать лид или саммари текста. Каждый раз он помещал материалы Guardian под одни и те же «подсказки», но в какой-то момент понял, что хочет экспериментировать с формулировками, а также автоматизировать этот процесс.

Так появился GuiLLeMot – расширение для браузера Chrome. Сейчас оно может придумать заголовок, написать лид или саммари текста. Как это работает? Журналист, редактор и любой, у кого есть доступ к плагину, находясь на странице с материалом, нажимает на иконку расширения и видит список опций: написать заголовок, лид и саммари. Когда пользователь кликает на задание, GuiLLeMot анализирует текст и предлагает релевантные ответы. При этом инструмент опирается на детальные подсказки, которые подготовили и зашили в расширение Крис и команда. Вот пример одной из них:

«Сгенерируй пять заголовков для The Guardian к этому тексту. The Guardian – это британская газета, и она не следует американским правилам для составления заголовков. Избегай таких кавычек: “Тело пожилого туриста было обнаружено в горах Колорадо. Его верную собаку нашли живой”. Это американский стиль, он не должен быть использован. (В британском правописании используют одинарные кавычки – прим. “Соли”). К тому же, по правилам The Guardian, заголовок должен кратко и внятно пересказывать ключевые моменты материала, которые обычно находятся в первом абзаце. Учитывай тему материала и примеры, которые я прикреплю внизу (…)».

Крис объяснил искусственному интеллекту нюансы британского оформления, приложил несколько примеров – реальных заголовков материалов The Guardian, а также попросил ИИ быть креативным и попробовать привлечь пользователей интересной, но ясной формулировкой. Он много экспериментировал с подсказками, детализировал их, чтобы ИИ следовал стандартам, но при этом действовал нестандартно.

Сейчас GuiLLeMot не применяют в работе The Guardian полноценно, то есть ни один из предложенных плагином заголовков не был опубликован. Но Крис и команда много советуются с редакцией, чтобы понять, насколько работа ИИ близка к тому, что нужно изданию, и продолжают тестировать GuiLLeMot. Некоторые результаты, по мнению Криса, действительно неплохи и могут, как минимум, дать журналистам импульс в работе.

«Мы не стремимся к идеальным заголовкам. Мы стремимся к такому набору заголовков, который может вдохновить человека, работающего над этим текстом», – говорит Крис Моран.

ИИ и редакционный кодекс

Параллельно Крис работает над ещё одним проектом – проверяет, может ли ИИ помогать находить ответы на спорные вопросы в журналистской практике. Всё это тоже про анализ данных – а конкретно редакционного кодекса The Guardian. Крис загрузил в ChatGPT многостраничный документ с описанием политики издания и предложил ИИ решить этическую проблему.

«Я спросил: источник только что заплатил за мой обед без моего ведома. Что я должен делать?» – приводит пример Крис. – «И чат-бот дал мне действительно хорошие ответы, опираясь на редакционный кодекс: “Хотя редакционный кодекс The Guardian не предоставляет решение для конкретно такого сценария, он описывает принципы, которым должны следовать журналисты, чтобы не ставить под угрозу редакционную независимость. Если источник заплатил за ваш обед без вашего ведома, попробуйте следующие действия:

- Признайте произошедшее: даже если этот жест был просто проявлением вежливости, принятие подарка может стать причиной конфликта интересов.

- Возместите расходы. Это поможет сохранить профессиональную границу между журналистом и источником.

- Сообщите редактору: прозрачность внутри организации важна.

- Задокументируйте инцидент и то как вы его решили: это может быть полезным в будущем для ваших коллег”».

Интересно, что ИИ может работать и как голосовой помощник.

«Если, например, журналисты находятся в поле или в другой стране, и у них нет времени, чтобы читать кодекс, они могут просто задать вопрос чат-боту и получить голосовой ответ, который будет соответствовать редакционным стандартам. Сейчас он может быть не совсем точным, но я думаю с этой штукой можно сделать много интересного», – говорит Крис Моран.

Опыт Лондонской школы экономики: журналистская этика и ИИ

Количество редакций, которые используют ИИ в работе, сильно выросло с момента релиза ChatGPT. Аналитический центр LSC (Лондонская школа экономики), который среди прочего изучает, как искусственный интеллект влияет на современную журналистику, сравнил результаты своих исследований за 2018 и 2023 года – и выяснил, что с прошлого года всё больше медиа находят применение генеративному ИИ в работе.

«Разнообразие вариантов использования ИИ было действительно интересным, – говорит Чарльз Бекетт, директор аналитического центра LSE. – «Довольно распространенное применение — это саммари материалов. Некоторые медиа, конечно, использовали ИИ для анализа большого объёма данных, и один из наиболее эффективных вариантов использования — это написание кода для разработки редакционных продуктов. Конечно, были и плохие кейсы применения ИИ».

Один из неудачных примеров – скандал с американским спортивным журналом Sport Illustrated, который разгорелся в ноябре прошлого года. Издание заподозрили в публикации материалов, сгенерированных искусственным интеллектом. Как только правда всплыла, медиа удалило материалы. Но случай вызвал бурные обсуждения о том, насколько этично использовать генеративный ИИ в журналистике.

Стандарты использования искусственного интеллекта в разных сферах, в том числе в журналистике, пока только формируются. Но, похоже, большинство разработчиков сходятся, что в конце любого процесса должен быть человек, который проверит работу системы. В противном случае это может обернуться, как в кейсе с Sport Illustrated, публикацией недостоверных фактов.

При этом ИИ может не только распространять дезинформацию, но и бороться с ней. В этом году LSE вместе с некоторыми британскими, немецкими и мексиканскими медиаорганизациями начала работу над амбициозным проектом Checkmate – веб-приложением, которое пробует проверять достоверность данных в видео и аудио в режиме реального времени.

«Будет невероятно сложно воплотить такое на практике, но может сработать. И это очень важная инновация. Вы не всегда будете успешны [в проверке данных], но можете научиться многому, просто пробуя и экспериментируя», – говорит Чарльз.

Чарльз Бекетт отмечает, что журналисты и другие работники ньюсрумов неизбежно столкнутся с искусственным интеллектом в работе, хотя бы потому что они будут писать о мире, где ИИ – неотъемлемая часть жизни. Понимать, как развивается и работает искусственный интеллект, – критически важно для работников медиа.

Чтобы интегрировать искусственный интеллект в работу редакции, LSE предлагает шесть простых шагов:

- следить за развитием ИИ;

- получать образование в области искусственного интеллекта;

- назначать ответственных за инновации и развитие;

- экспериментировать снова и снова;

- разработать редакционные стандарты;

- сотрудничать с другими медиа: обмениваться опытом в использовании ИИ.

«Одно из замечательных событий последнего года — это количество людей, у которых теперь в названии должности есть «ИИ». Это быстро развивающаяся область, и редакциям нужно иметь специалиста, который разговаривает со всеми остальными в отделе новостей, следит за развитием событий, читает исследования и наблюдает за тем, что делают другие новостные организации», – заключил Чарльз Бекетт.