Вы наверняка видели нашумевшие видео с Зеленским, объявляющим капитуляцию в марте 2022 года. После полномасштабного вторжения России в Украину ролик разлетелся по сети, но быстро был разоблачён: он оказался дипфейком.

Поначалу синтетические фото и видео были довольно очевидными, но ИИ учится на своих ошибках, и теперь отличить реальность от подделки становится всё сложнее. Как итог: в 2024 году, когда голосует почти половина населения Земли, количество дипфейков в онлайн-медиа выросло на 68%, по данным исследования Sumsub, компании, которая занимается цифровой верификацией и защитой.

Мы подготовили тест, чтобы проверить, насколько легко вы клюёте на фальшивку. А в конце вас ждут советы, как вычислить подделку, даже если она идеальна.

Что из этого чаще всего выдаёт дипфейк?

Обращайте внимание на кожу. ИИ генерирует всё более реалистичные дипфейки, но сделать лицо естественным сложно. Даже через морщины может проглядывать странно гладкая кожа. Это явный признак фальшивки.

Какие детали часто остаются непродуманными в дипфейках?

Всё-таки самые частые ошибки ИИ допускает при создании аксессуаров и одежды. Серёжка только в одном ухе, непропорциональный воротник рубашки, странные пуговицы – это может указывать на ИИ-происхождение изображения или видео

Какие технологии помогают улучшить точность распознавания дипфейков?

Нейронные сети – одна из самых эффективных технологий для распознавания дипфейков. Чтобы выявить подделки, они анализируют пиксели, текстуры и аномалии, которые не видны невооружённым глазом.

Какой метод защиты от дипфейков популярен в последнее время?

Лучше всего сегодня работают водяные знаки. Даже алгоритмы распознавания не так надёжны. Всё потому, что технология дипфейков постоянно развивается и улучшает методы обхода фильтров-индикаторов. А водяные знаки внедряются непосредственно в контент и помогают идентифицировать источник.

Какой элемент лица чаще всего бывает неправильно сгенерирован в дипфейках?

Самая проблемная зона для ИИ – это уши. Нейросеть забывает про второе ухо, делает его неподходящим по размеру или располагает несимметрично.

Какой метод наиболее надёжный для проверки подлинности видео?

Наиболее надёжный метод – анализ метаданных файла. Они могут содержать информацию о времени и месте создания фото или видео, устройстве, на которое оно было снято, и другие подсказки. Кроме того, метаданные сложно подделать – это хороший метод проверки подлинности.

Что из этого наиболее свойственно голосовому дипфейку?

Из всего перечисленного наиболее свойственный голосовому дипфейку признак – ровный тембр и интонация. Искусственный интеллект часто генерирует речь без эмоций, естественного произношения и даже пауз. На выходе получается монотонное звучание. Обращайте внимание на плавность и ритм.

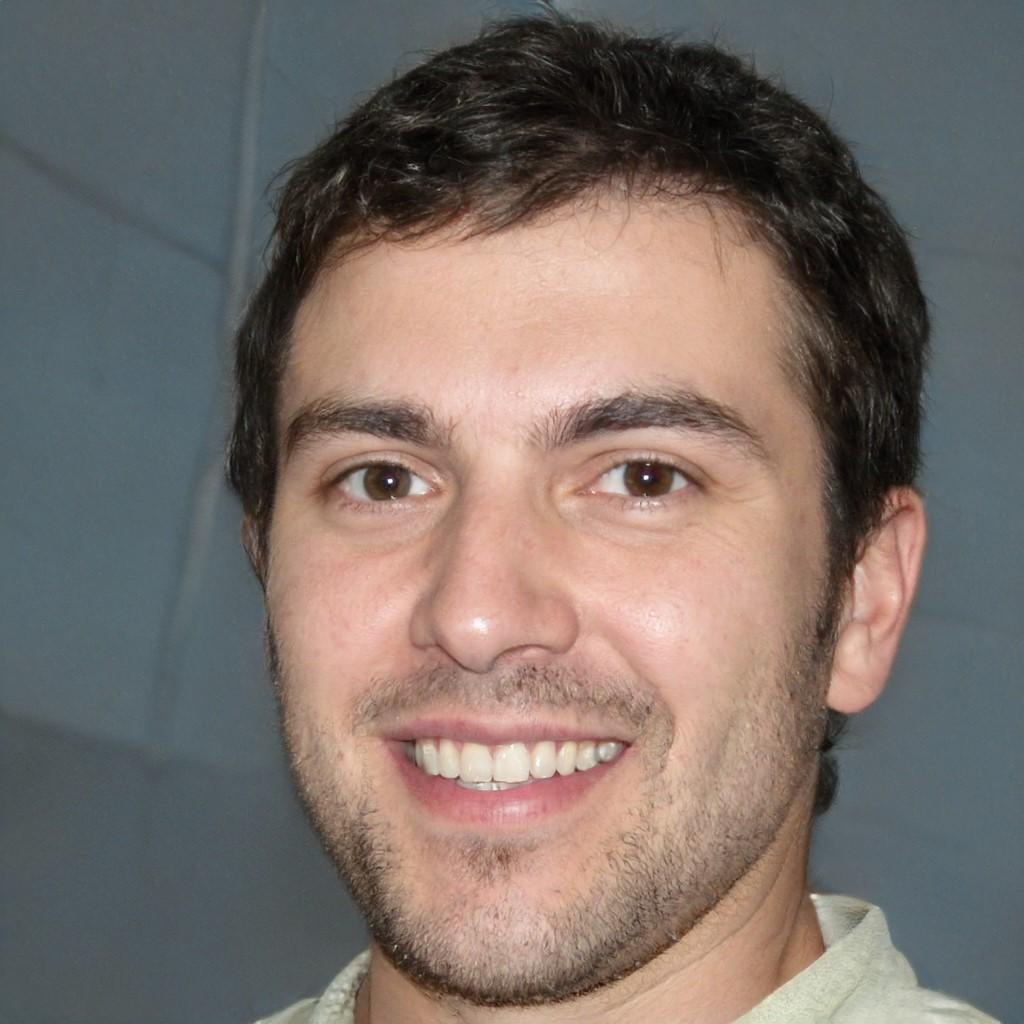

Отлично! Теперь примеры. Реальный ли человек на фото?

Это дипфейк. Хотя очень реалистичный! Присмотритесь к деталям: что за странный зуб в правом уголке рта, куда поплыла плитка на фоне и почему свет в зрачках отражается под разными углами?

Реальный ли человек на фото?

Это реальный человек. На фото – британская актриса и предпринимательница Лили Коул

Это реальное фото?

Обратите внимание на кожу. Она ненатурально гладкая. Это дипфейк. Сторонники Трампа распространили несколько подобных изображений, чтобы создать у темнокожих американцев положительный образ бывшего президента

Это Морган Фриман или его ИИ-копия?

Это дипфейк, который появился в сети в 2022 году. На видео ИИ-копия актёра сообщает зрителям, что то, что они видят, неправда, и объявляет об эпохе «синтетической реальности».

А это дипфейк?

Это не ИИ-копия Владимира Зеленского, а реальные кадры с ним.

Как насчёт этого видео?

Это очередной дипфейк с Томом Крузом. И их полно. Ищите примеры по хештегу #deeptomcruise, чтобы понять, насколько реалистичным может быть результат работы ИИ.

Советы. Как распознать дипфейк?

- Как выглядит человек?

Искусственному интеллекту всё ещё довольно сложно работать с деталями. Проверьте, все ли уши на месте, одинаковое ли количество пальцев на руках, в порядке ли зубы и моргает ли человек на видео – эти нюансы довольно проблемные для нейросети.

- Как звучит человек?

В дипфейках люди часто говорят странно: монотонно, без пауз, используют нехарактерные слова или даже говорят на языках, которыми не владеют. А ещё часто движение губ и речь не совпадают. Прислушайтесь к говорящему. Если есть сомнения – проанализируйте другие факторы.

- Что вокруг?

На фоне фейковых изображений и видео часто можно увидеть неразборчивый текст. При этом понять, на каком языке он написан, сложно: часто это просто набор символов, напоминающий буквы или иероглифы. Также предметы на заднем фоне могут «поплыть» или наслоиться друг на друга. Особое внимание уделите теням и отражениям – в дипфейках они часто нарушают законы физики.

- Что вы знаете о изображении/видео?

Проверьте метаданные. Так вы сможете узнать локацию, дату и время создания файла и сравнить с заявленным. Некоторые фото/видео могут сохранять информацию о редактировании: какие программы использовали для изменения и когда. Подробнее о верификации фото и видео читайте в нашем материале.